2025年4月は OpenAI のモデルリリースラッシュがきましたが、すでに Azure 側でも利用可能な GPT-4.1 ファミリーと o3, o4-mini について自分用ざっくりなメモです。

先週発表されて、GPT-4.1 family と o4-mini は自分の Azure の環境で即日利用可能になったけど、o3 はまだ使えず💦 今日まで待ってみたけど使えないままだからもー諦めてブログ公開しました💦

- GPT-4.1, GPT-4.1 mini, GPT-4.1 nano のざっくりまとめ

- o3, o4-mini ざっくりまとめ

- ちょっと詳細メモ: GPT-4.1 model family

- ちょっと詳細メモ: o3, o4-mini

- 参考

GPT-4.1, GPT-4.1 mini, GPT-4.1 nano のざっくりまとめ

GPT-4.1 ファミリー概要

- すべてファミリーで input token 100万 (1047k)、output は 32k

- 以前の GPT-4o や GPT-4o-mini, GPT-4.5 (input: 128k, output: 16k) に比べ大幅アップ

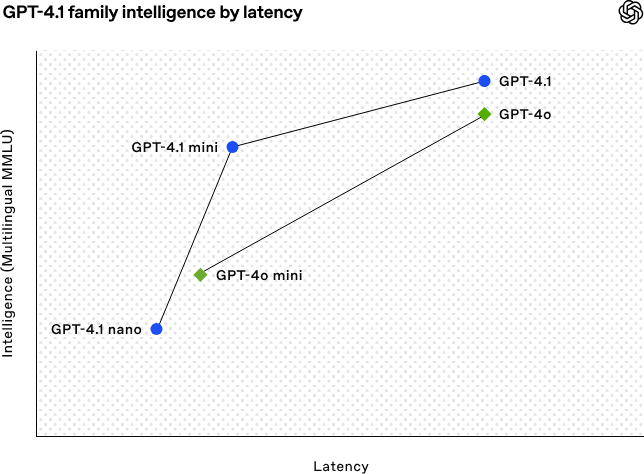

- 性能とパフォーマンスの比較は以下。

- この登場により GPT-4.5-preview は廃止予定 (2025年7月14日)

性能とコストからして GPT-4o から GPT4.1 へ移行するのがベター

価格はこんな感じ。

| Model | Input (1M token) | Output (1M token) |

|---|---|---|

| GPT-4.1 | $2.00 | $8.00 |

| GPT-4.1-mini | $0.40 | $1.00 |

| GPT-4.1-nano | $0.10 | $0.40 |

| GPT-4o | $2.50 | $10.00 |

| GPT-4o-mini | $0.15 | $0.60 |

| GPT-4.5 | $75.00 | $150.00 |

ドキュメントの性能通りに動作する前提であれば以下は考えたくなるところ。

- GPT-4o は GPT-4.1 へ移行、GPT-4.1-mini でいけるかも。

- GPT-4o-mini は GPT-4.1-mini へ移行、GPT-4.1-nano でいけるかも。

ベンチマークとリアルワールドでの性能は異なるのでちゃんと評価してから移行しましょうってのは当たり前の前提ですが。

100万トークン入るなら RAG は不要に?

そんなこという人もいるかもしれませんが、OpenAI-MRCR Accuracy のベンチマークを見ればわかる通り、8k をこえると一気に Accuracy がさがります。 以前から大幅によくなったかもしれませんが、4 needles ならさらに顕著に Accuracy がさがります。8 needles だとそもそも縦軸が0-100% ではなく 0-55%です。 リアルワールドで RAG やっててこのスコアなら...ねぇって感じです。 つまり100万トークンぶっこむ = コスト爆上げなので、コスト上げて精度下げる手法を選ぶ必要性は...私は感じません。 コーディング系のタスクで大きなトークン数をぶっこめるのという用途的というのが個人的な認識。

使ってみた所感

AutoGen を使った multi agent なアプリで利用してみると、今までの GPT-4o や GPT-4o-mini と比べてはるかに挙動がよくなった。回答が優れるってことはそこまでないないが (それは個々の Agent の精度や RAG の精度にも依存するので)、ポンコツな挙動がかなり減った印象。

o3, o4-mini ざっくりまとめ

o3, o4-mini 概要

o3 についてはとりあえず現時点で万能の最強モデルの位置づけ。

o4-mini は、AIME 2025 (全米のトップクラスの高校生を対象とした数学コンテスト) では Python interpreter へのアクセス可能な状態で99.5%、o3 を上回る。Python の interpreter なしでも o3 を上回ってるし、以前の model (o1, o-3-min) よりももちろん上。コーディングもベンチマーク的にはかなり強化が入った印象。 GPT-4.1 family も同様だが昨今の Vibe coding ブームに勝ち残るのこるためこのあたりの強化をしてきた雰囲気を感じる。

さっといじった印象でも、ポンコツな動作が減った気がする。回答もすごくいい気がする。

画像の分析では思考の連鎖を組み込むことができるようになり、視覚的推論とテキストの推論によるパフォーマンスの向上がなされたようなので、こちらも期待できそう (画像関連はここ最近試したいことがなくて試してない)。

性能とコストからして新しい model への移行がベター

価格はこんな感じ。

まずは o3 vs o1 だけど、性能めちゃあがって価格が安くなってるので移行って感じ。

| Model | Input (1M token) | Output (1M token) |

|---|---|---|

| o3 | $10.00 | $40.00 |

| o1 | $15.00 | $60.00 |

o4-mini vs o3-mini は価格据え置きなので、性能が明らかに上な o4-mini への移行ですね。

| Model | Input (1M token) | Output (1M token) |

|---|---|---|

| o4-mini | $1.10 | $4.40 |

| o3-mini | $1.10 | $4.40 |

さっきも同じこと書いたけど、ベンチマークとリアルワールドでの性能は異なるのでちゃんと評価してから移行しましょうっての言うまでもない前提です。

ちょっと詳細メモ: GPT-4.1 model family

GPT-4.1 model family に関するめちゃ細かい話は OpenAI のリリースドキュメント見るとして、ここでは個人的にさっとメモしておきたいことをあげます。

Instruction following

- 全体的にリアルワールドを意識してトレーニングをしたようなので、エンタープライズなアプリの利用でより性能の恩恵を得れそう。

- OpenAI での internal な評価を開発しそのメトリクス基づいてトレーニングをしており、Instruction following (指示への追従) に重点をおいているので、プロンプトの指示・制約が強くなっているらしい。この評価メトリクスの影響かここ最近のモデルがどんどん強くなってる感あるので 4.1 ファミリーも期待できそう。

Long Context

100万トークンについては、評価の結果をみてすごくパフォーマンスが上がった感じはあるけど、 少ないほうが精度が高くなる傾向にあるという意味でベストに違いない。

- 今回の評価結果でも見てわかる通り特に8Kの壁は、個人的に何度も感じたことがあるがいまだに大きい。

- Multi hop のロングコンテキストの評価の向上もいい感じなので、コーディング系で o1 とか o3-mini の代替になれるかもと期待。

Vision

画像は全然試してないけどとりあえず書いてあったことを...

- 画像の理解は GPT-4.1-mini でも GPT-4o 以上のベンチマークを出している

- long context の動画も強い

ちょっと詳細メモ: o3, o4-mini

ベンチマーク見ながら「へー」くらいな感じだったり、Contents Safety の話や Codex の話もあったけど、メモしておきたいことは特になしでした😅